Meta questa settimana ha annunciato un nuovo modello di intelligenza artificiale (AI) open source che collega più tipi di dati inclusi testo, audio, dati visivi, temperatura e letture di movimento. Il modello è solo un progetto di ricerca al momento, senza applicazioni pratiche o di consumo immediate. Tuttavia, punta a un futuro di sistemi di intelligenza artificiale generativa in grado di creare esperienze coinvolgenti e multisensoriali. Il suo nome è Meta ImageBind e vi spieghiamo come funziona.

Meta introduce ImageBind un nuovo modello di intelligenza artificiale multisensoriale open source. Ecco come funziona e cosa può fare

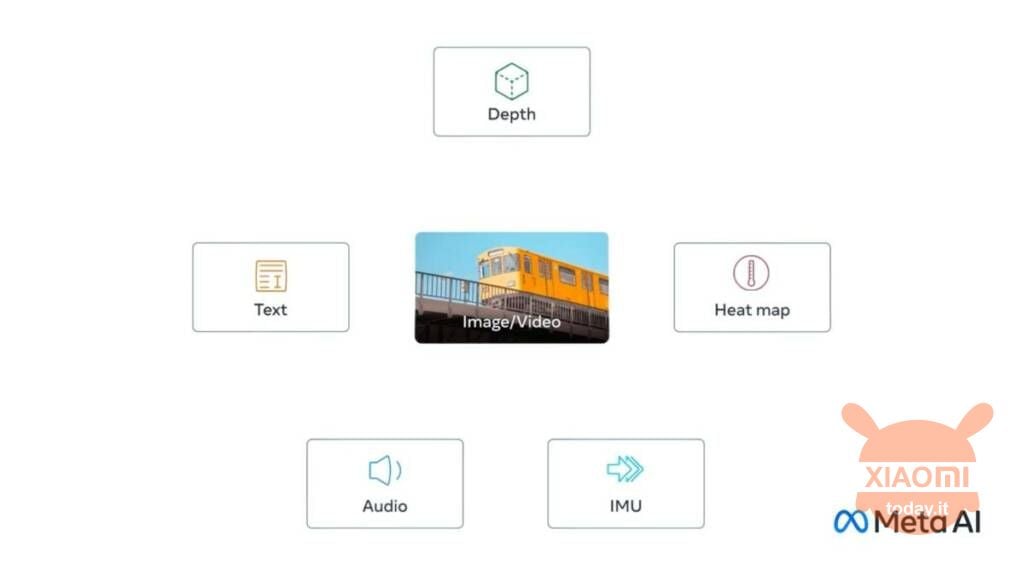

La novità si chiama Meta ImageBind ed è la prima a combinare sei tipi di dati in un unico spazio multidimensionale. I sei tipi di dati inclusi nel modello sono:

- Visivi (sotto forma di immagini e video)

- Termici (imaging a infrarossi)

- Testi

- Audio

- Informazioni approfondite

- Letture del movimento generate da un’unità di misura inerziale, o IMU

Leggi anche: Meta presenta SAM, la AI che identifica singoli elementi all’interno di immagini

L’idea è che i futuri sistemi di intelligenza artificiale possano fare riferimenti incrociati a questi dati nello stesso modo in cui i sistemi attuali fanno per l’inserimento di testo. Immaginiamo, ad esempio, un dispositivo di realtà virtuale futuristico che genera non solo input audio e visivi, ma anche il nostro ambiente e il nostro movimento su un palcoscenico fisico. L’utente potrebbe chiedere allo strumento di emulare un lungo viaggio in mare, e non solo lo metterebbe su una nave con il fragore delle onde in sottofondo, ma anche il ponte ondeggiante sotto i piedi e la fresca brezza dell’aria dell’oceano. L’idea è che la piattaforma combini vari formati di dati per generare il risultato.

In un post sul blog, Meta osserva che altri flussi di input sensoriali potrebbero essere aggiunti ai modelli futuri, inclusi “tocco, parola, olfatto e segnali cerebrali fMRI“. Questa funzionalità appena rilasciata non è ancora pronta, quindi la community non è in grado di testarla in questo primo momento, anche se è in una fase avanzata di sviluppo.